전이 학습(Transfer Learning)

- 인공지능 및 데이터과학/머신러닝 및 딥러닝

- 2021. 12. 6.

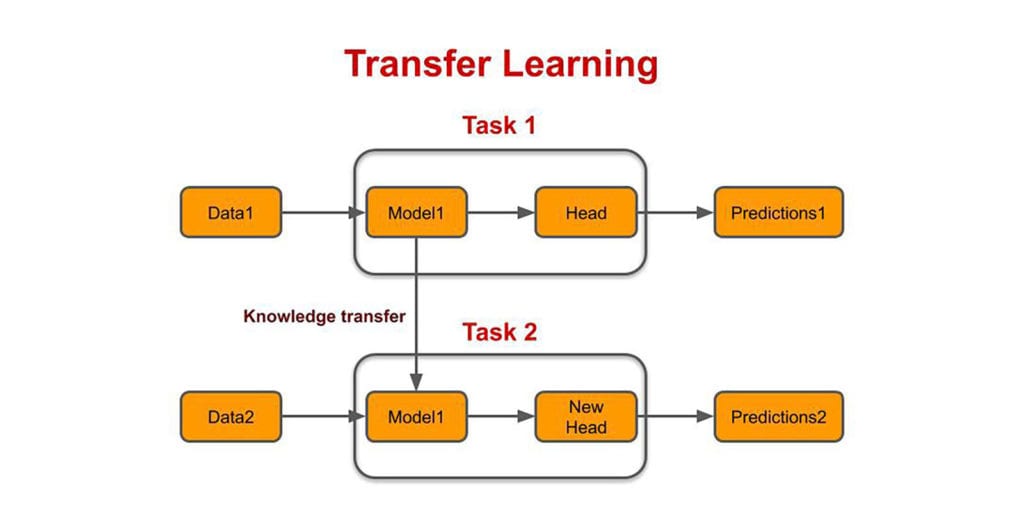

트랜스퍼 러닝(Transfer Learning) 즉 전이 학습은 특정 태스크에서 학습된 모델을 이용하여 다른 태스트에 재사용하는 기법을 말한다. 전이 학습은 최근 들어 자연어 처리 분야에 상당 부문 많이 활용이 되고 있는데 BERT(Bidirectional Encoder Representations from Transformers)나 GPT(Generative Pre-trained Transformer)와 같은 모델을 이용하여 대규모의 데이터셋을 학습하고 이 학습된 모델을 토대로 다른 분야에 많이 활용 되곤 한다.

전이학습을 사용하는 이유

일반적으로 전이학습이 없이 모두 한번에 학습하는 일반적인 방식은 속도도 매우 오래 걸리고, 태스크(Task)간의 최적화를 이루어낼 수 없다. 이를 현실 세계로 예시를 들어본다면, 우리가 어떤 과학 문제를 푸는데 지문이 매우 난해할 경우 과학 문제를 잘 푸는 사람이라 하더라도 독해 능력으로 문제를 맞추지 못할 수 있다.

자연어 처리(NLP)쪽도 마찬가지이다. 결국 문맥(Context)을 잘 이해하는 모델이 있다면 이 문맥을 이해하는 모델을 기반으로 다양한 최종 서비스를 더욱 정교하게 만들어 낼 수 있다.

문맥을 잘 이해시키는 대표적인 기술로는 빈칸을 맞히는 BERT와 다음 단어를 예측하는 GPT가 대표적인데 이와 같이 문맥을 매우 잘 이해하는 모델을 사용하여 전이학습을 활용하게 되면 전반적인 학습 속도도 빨라지고, 성능도 매우 큰 폭으로 오를 수 있다.

업스트림, 다운스트림

전이학습에 사용되는 태스크는 업스트림(Upstream) 태스크라 불린다. 한마디로 BERT와 GPT를 이용하여 학습한 모델을 업스트림 태스크라 이해하면 되고, 이를 전이학습을 통해서 새로운 서비스를 창출한 태스크를 다운스트림(downstream) 태스크라 한다.

이때 업스트림 태스크를 학습하는 과정은 프리트레인(pretrain), 다운스트림 태스크를 학습하는 과정은 파인튜닝(finetuning)이라 부른다.

자기지도 학습(Self-supervised learning)

GPT나 BERT와 같은 모델이 성능이 좋은 이유는 매우 좋은 정답 셋 데이터를 기반으로 자기지도 학습을 하고 있기 때문이다. 분류 문제나 감성 분석, 스팸 필터 등과 같은 데이터는 인간이 직접 분류를 해야 한다던지 분류를 하더라도 완벽한 분류가 나오기 힘들다. 하지만 BERT와 GPT와 같은 데이터는 이미 위키피디아나 뉴스 데이터와 같은 양질의 데이터를 활용하여 데이터를 학습할 수 있다.

여기에 BERT와 GPT는 단어만 예측하면 되기 때문에 매우 쉽게 정답을 만들어 내고 학습을 할 수 있기 때문에 GPT와 BERT 모델이 좋은 성능을 발휘할 수 있는 것은 당연할 것이다.

'인공지능 및 데이터과학 > 머신러닝 및 딥러닝' 카테고리의 다른 글

| [Python] 해밍 거리(Hamming distance) 이해 및 구현하기 (0) | 2022.01.13 |

|---|---|

| 자카드 유사도(Jaccard Similarity) 개념 이해 및 Python 구현 (0) | 2022.01.09 |

| [머신러닝] 모멘텀(Momentum), NAG 옵티마이저 (0) | 2021.06.19 |

| [머신러닝] 확률적 경사하강법(Stochastic Gradient Descent, SGD) (0) | 2021.06.05 |

| [머신러닝] 옵티마이저(Optimizer)란? (0) | 2021.06.05 |